三LSTM的应用机器翻译应用描述LSTM在机器翻译中用于将源语言句子自动翻译成目标语言句子关键组件编码器Encoder一个LSTM网络lstm,负责接收源语言句子并将其编码成一个固定长度的上下文向量解码器Decoder另一个LSTM网络lstm,根据上下文向量生成目标语言的翻译句子流程源语言输入将源语言句子分词并转换。

长期依赖 LSTM通过引入遗忘门输入门和输出门,以及内部记忆单元,能够更有效地捕捉长期依赖关系记忆单元c中保存信息的生命周期长于短期记忆,但远远短于长期记忆,因此LSTM被称为长短期记忆梯度问题 LSTM通过精细的门控机制,能够在一定程度上缓解梯度消失和梯度爆炸问题然而,在训练LSTM网络时,过小。

长短期记忆网络long shortterm memory,LSTM是一种特殊的循环神经网络RNN,旨在解决RNN在处理长序列数据时遇到的短期记忆问题LSTM通过引入称作“门”的内部机制来调节信息流,从而能够更有效地捕捉时间序列中时间步距离较大的依赖关系一LSTM的核心结构 LSTM的核心结构包括三种类型的门输入门。

BP神经网络和LSTM神经网络在时间序列处理上的核心区别在于结构机制长期依赖捕捉能力及适用场景,LSTM通过门控机制和记忆单元更擅长处理长序列数据结构与信息处理机制BP神经网络采用多层前馈结构,信号单向传递,通过反向传播算法调整权重其训练依赖梯度下降法,但存在梯度消失问题随着网络层数加深,浅层权重。

LSTM的原理 LSTMLong ShortTerm Memory,长短期记忆是一种特殊的RNNRecurrent Neural Network,循环神经网络结构,其核心思想在于通过引入门机制来控制信息的流动,从而解决传统RNN在长期依赖问题上的不足LSTM的原理可以概括为“吐故纳新,沙里淘金”,整个过程类似于在煮老汤,不断筛选和保留。

循环神经网络LSTM详解 长短时记忆网络Long Short Term Memory,简称LSTM是具有记忆长短期信息能力的神经网络,与RNN同属于循环神经网络RNN的范畴但相较于传统的RNN,LSTM在解决长期依赖问题上具有显著优势一LSTM的提出背景 当输入序列过长时,RNN的权重矩阵需要循环相乘,这会导致梯度消失。

LSTM结构及参数详解 一LSTM结构 LSTMLong ShortTerm Memory,长短期记忆网络是一种特殊的循环神经网络RNN,旨在解决传统RNN在处理长序列数据时存在的梯度消失和梯度爆炸问题LSTM通过引入三个门结构遗忘门记忆门和输出门以及细胞状态,实现了对信息的长期存储和有效传递遗忘门Forget。

LSTM网络模型的优缺点优点适用于时间序列数据LSTM网络特别适用于处理时间序列数据,如自然语言处理语音识别手写体识别等它能够捕捉序列数据中的长期依赖关系,这是传统RNN所难以做到的缓解梯度消失问题通过引入门机制,LSTM网络能够控制信息的流动,从而在一定程度上缓解了RNN在训练时反向传播带来。

示例对于长文本,可以按标点符号分句或分段,对每个句子使用LSTM进行特征抽取固定最大长度,截取多余的部分 方式说明设定一个固定的最大序列长度,对超过该长度的部分进行截取选择截取位置一般选在开头或结尾,如进程日志的开头和结尾往往是常规流程,与核心内容无关问题可能造成数据丢失的风险。

目前的强化学习里深度网络较少用transformer,而更多用lstmrnn这类网络的原因主要有以下几点一强化学习的特性与rnnlstm的契合度 顺序依赖性强化学习中的决策过程往往具有顺序依赖性,即当前的状态和动作会影响后续的状态和奖励rnn和lstm这类网络由于具有顺序结构,能够很好地捕捉这种顺序依赖性,从而更准确。

LSTM与Transformer的创新结合 一创新点概述 在深度学习领域,LSTM长短期记忆网络和Transformer是两种重要的序列处理模型LSTM以其强大的序列建模能力而著称,而Transformer则以其高效的并行计算能力和长距离依赖捕捉能力受到广泛关注近年来,研究者们开始探索将LSTM与Transformer进行创新性结合,以融合两者。

长短期记忆网络LSTM长短期记忆网络LSTM是一种特殊类型的循环神经网络RNN,旨在解决标准RNN在处理长序列数据时面临的梯度消失和梯度爆炸问题一历史背景与概念的提出 LSTM的历史背景可以追溯到20世纪90年代中期,最初由Sepp Hochreiter和Jürgen Schmidhuber于1997年提出他们的研究旨在解决RNN在。

人人都能看懂的LSTM 循环神经网络Recurrent Neural Network,RNN是一种专门用于处理序列数据的神经网络在处理如文本时间序列等具有前后依赖关系的数据时,RNN能够展现出强大的能力然而,普通的RNN在处理长序列数据时,容易遇到梯度消失或梯度爆炸的问题,导致无法有效捕捉长距离依赖关系为了解决这个。

LSTM与GRU的原理LSTM长短期记忆网络的原理LSTM是为了解决简单RNN面临的长期依赖问题而设计的,其核心在于引入了三个门来控制信息的传递,分别是遗忘门输入门和输出门遗忘门控制上一时刻的内部状态需要遗忘多少信息遗忘门的输入是上一时刻的外部状态$h_t1$和当前时刻的输入$x_t$。

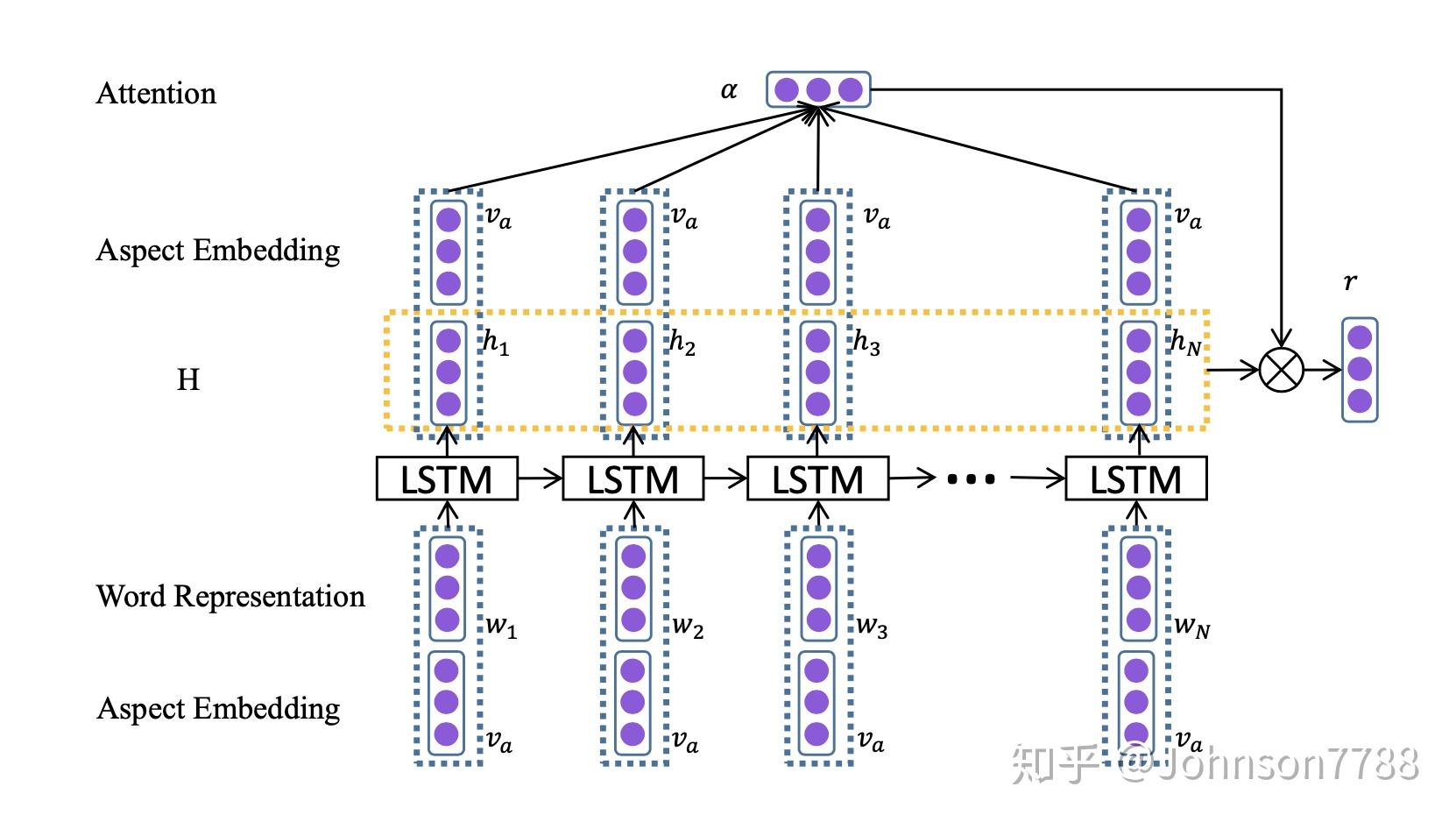

LSTM+Attention确实再次展现了强大的性能,刷新了多个领域的记录LSTM长短期记忆网络在处理序列数据方面有着独特的优势,而注意力机制则通过模仿人类的注意力分配方式,进一步提升了模型在处理复杂任务时的性能以下是对LSTM+Attention组合的详细解析,以及几篇相关论文的亮点介绍LSTM与注意力机制的结合。

长短期记忆网络Long ShortTerm Memory, LSTM是一种特定类型的递归神经网络Recurrent Neural Network, RNN,专为解决标准RNN在处理长序列数据时面临的梯度消失问题而设计自提出以来,LSTM因其卓越的时间序列处理能力,广泛应用于自然语言处理语音识别音频分类等领域本文将详细介绍LSTM的原理。

长短期记忆网络和门控制网络的主要区别如下门机制数量LSTM具有四个门机制,分别是遗忘门输入门更新门和输出门这四个门机制共同协作,实现对信息的长距离记忆和遗忘GRU简化了门机制,仅保留了重置门和更新门两个关键步骤,从而降低了计算复杂度计算复杂度LSTM由于具有四个门机制。

相关标签 :

上一篇: windowsthinpc,windows19872024

下一篇: 2018新年图片,20182021图片

微信医疗(登记+咨询+回访)预约管理系统

微信医疗(登记+咨询+回访)预约管理系统  云约CRM微信小程序APP系统定制开发

云约CRM微信小程序APP系统定制开发  云约CRM体检自定义出号预约管理系统

云约CRM体检自定义出号预约管理系统  云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统

云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统  云约CRM新版美容微信预约系统门店版_门店预约管理系统

云约CRM新版美容微信预约系统门店版_门店预约管理系统 云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统

云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统联系电话:18300931024

在线QQ客服:616139763

官方微信:18300931024

官方邮箱: 616139763@qq.com