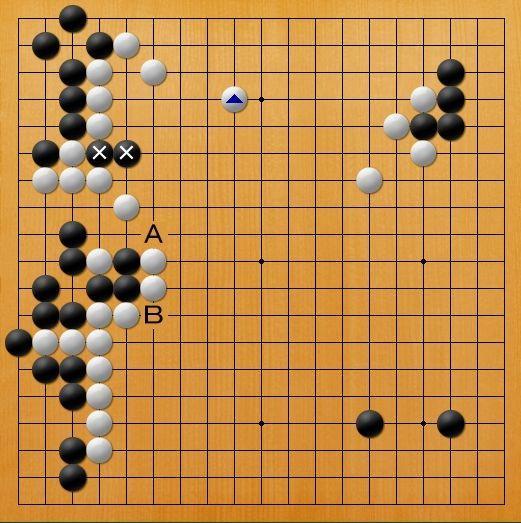

1、AlphaGo Zeroalphagozero的前世今生总结及未来展望前世 基础积累AlphaGo Zero的成功并非一蹴而就,它建立在人工智能界长期的积累和研究基础上传统的解决方案如基于搜索的算法和基于评价的方法,在围棋等智力游戏中有所应用,但围棋的复杂性使得这些方法面临巨大挑战 强化学习探索AlphaGo Zero通过强化学习;阿尔法元的革命性突破深度强化学习的围棋新纪元 阿尔法元的诞生,无疑是人工智能领域的一次里程碑,它以超越阿尔法狗的卓越表现,展现alphagozero了深度强化学习的无与伦比的潜力新算法Alphago Zero,摒弃了人类数据的依赖,仅仅依靠自alphagozero我学习,揭示了强化学习在复杂决策中的强大能力谷歌的TPU为其提供了强大的计算支持,让深度学习;围棋的软件排名为AlphaGo ZeroLeela ZeroCrazy Stone围棋天地巨石围棋围棋是一种传统的中华文化,拥有深厚的历史文化底蕴和艺术魅力随着科技的不断进步,围棋软件应运而生,赢得了广泛的关注和欣赏1AlphaGo ZeroAlphaGo Zero是谷歌研究团队发布的一款超强围棋人工智能,它在2017年秋季开发;上图是根据在自然上发表的文章绘制,解释了AlphaGo Zero是怎样将深度学习和蒙特卡洛树搜索结合,使之具有超强的强化学习算法能力AlphaGo Zero的工作原理 简单来说,AlphaGo Zero的训练可以分为三个同时进行的阶段自我对战再训练网络评估网络自我对战阶段AlphaGo Zero创建一个训练集合,自我完成;2016年,AlphaGo与围棋世界冠军李世石的对弈,以4比1的比分见证了人工智能的崛起随后,它以“Master”身份挑战中日韩顶尖高手,连续60局无败绩,震撼了围棋界2017年5月,AlphaGo与世界冠军柯洁的对决,以3比0的压倒性胜利,标志着人工智能在围棋领域已达到人类顶尖水平自学成才的AlphaGo Zero AlphaGo;也由于使用了更多的算法和更少的数据,所以AlphaGoZero只使用了一台计算机器和4个TPU,被它打败的一代AlphaGo则用到多台机器和48个TPU当人们惊讶于AlphaGoZero在围棋领域的神级水平时,对于DeepMind团队来说,这才只是刚刚开始,他们的目的是通过培养自主学习的能力,来解决更多其他领域目前无法解决的棘手。

2、AlphaGo Zero的工作原理可以用以下一张图的内容进行概括核心结合AlphaGo Zero结合了深度学习和蒙特卡洛树搜索,使其具备强大的强化学习算法能力训练阶段自我对战AlphaGo Zero首先进行大量的自我对战,存储每次棋局变动博弈搜索可能性和胜出者的信息再训练网络从大量博弈中选取样本,优化神经网络的;AlphaGoZero使用新的强化学习方法,让自己变成了老师系统一开始甚至并不知道什么是围棋,只是从单一神经网络开始,通过神经网络强大的搜索算法,进行了自我对弈随着自我博弈的增加,神经网络逐渐调整,提升预测下一步的能力,最终赢得比赛更为厉害的是,随着训练的深入,DeepMind团队发现,AlphaGoZero还独立;次,每变动一次棋局,博弈搜索可能性和胜出者的信息都会被存储在训练网络阶段,神经网络的权值得到优化AlphaGo Zero从50万局博弈中选取2048个移动位置作为样品,对;Leela Zero 开源特性LeelaZero是基于AlphaGo Zero理念开发的围棋AI,且是开源的,用户可以从githubcomleelazeroleelazero下载 版本选择提供无需显卡的CPU版本和利用显卡加速的版本 图形界面为了与LeelaZero配合使用,建议下载图形界面软件Sabaki,下载地址为githubcomSabakiHQSabaki 权重文。

3、AlphaGo Zero解读如下核心机制改进单一网络的融合AlphaGo Zero将actor和critic网络合并为一个,简化了模型结构,提高了学习效率这一改进使得模型能够同时输出动作概率和状态价值,从而更有效地指导自我学习和决策过程自我学习机制AlphaGo Zero完全摒弃了使用人类对弈数据进行预训练的步骤,转而依赖强化;强化学习原理AlphaGo采用强化学习原理进行训练,这是一种通过与环境互动并基于奖励信号来学习策略的方法每一步棋的落子都被视为一个行为选择,成功的棋步会得到正向奖励,从而强化其策略,而失败的棋步则得到负向奖励,促使其避免类似错误自我对弈与深度学习AlphaGoZero,作为AlphaGo的升级版,完全从;AlphaGo Zero 以1000秒杀前任阿法狗 AlphaGo Zero在2017年10月19日由DeepMind发布,其强大的表现震惊了围棋界它不仅在40天内秒杀了以往所有AlphaGo的版本,包括曾经战胜世界围棋冠军李世石九段棋手的阿法狗,而且是以1000的悬殊比分获胜这一成就的背后,是AlphaGo Zero独特的训练方式和算法优化;AlphaGo Zero是谷歌下属公司Deepmind的新版程序从空白状态学起,在无任何人类输入的条件下,AlphaGo Zero能够迅速自学围棋,并以1000的战绩击败“前辈”2017年10月19日凌晨,在国际学术期刊自然Nature上发表的一篇研究论文中,谷歌下属公司Deepmind报告新版程序AlphaGo Zero从空白状态学起,在无。

4、与前几个版本AlphaGo不同,此版本的AlphaGoZero完全不受人类思维束缚,因此算作革新性人工智能AlphaGoZero的能力有了质的提升最大的区别是,它不再需要人类数据也就是说,它一开始就没有接触过人类棋谱研发团队只是让它自由随意地在棋盘上下棋,然后进行自我博弈作用1AlphaGo本身就是google;AlphaGo Zero,这款围棋AI,展示了机器学习的惊人能力它仅通过自我对局,无需人类对局数据的训练,就在短短三天内超越了AlphaGo李版本,并在21天后击败了AlphaGo MasterDeepMind在开发AlphaGo Zero后,其论文成为了围棋AI开发的基础各大科技公司如腾讯Facebook腾讯微信团队等,均据此开发出自家的。

5、他们推出了AlphaGo Zero,这个版本并没有使用人类的棋谱,而是仅仅教会了电脑围棋的规则,然后让电脑不断进行自我对弈通过自我对弈,AlphaGo Zero在短短几天内就达到了业余高段的水平,并在第三天以100盘全胜的战绩战胜了自己的上一个版本这一成就再次证明了深度学习技术的强大和高效 五Alpha Zero的多领域拓展。

6、AlphaGo Zero是DeepMind在Nature上发表的一篇论文中描述的最新版本的AlphaGo这款AI在与战胜李世石版的AlphaGo Lee的对局中,打出了1000的惊人战绩以下是对AlphaGo Zero的详细解读一主要改进 网络结构合并AlphaGo Zero将之前的AlphaGo中的actor网络和critic网络合并为一套,同时输出所有动作的选择概率。

下一篇: 蓝色导航条,蓝色导航怎么了

微信医疗(登记+咨询+回访)预约管理系统

微信医疗(登记+咨询+回访)预约管理系统  云约CRM微信小程序APP系统定制开发

云约CRM微信小程序APP系统定制开发  云约CRM体检自定义出号预约管理系统

云约CRM体检自定义出号预约管理系统  云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统

云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统  云约CRM新版美容微信预约系统门店版_门店预约管理系统

云约CRM新版美容微信预约系统门店版_门店预约管理系统 云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统

云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统联系电话:18300931024

在线QQ客服:616139763

官方微信:18300931024

官方邮箱: 616139763@qq.com