1、3 深度学习模型深度学习模型在处理高维数据方面表现出色,如深度神经网络DNN卷积神经网络CNN循环神经网络RNN等,它们能够通过自动提取数据特征的方式来降低维度,同时也能够利用GPU等硬件进行并行加速4 数据压缩与分布式处理另一种处理大规模数据的方法是利用数据压缩和分布式处理技术CNN模型压缩与加速算法综述开发者社区;PaddleSlim,百度研发的自动化压缩工具,其宣讲内容及后续跟进记录如下模型压缩方法包括NAS非结构化稀疏剪枝量化加速原理工具支持等PaddleSlim的自动化压缩工具ACT,支持离线量化与量化训练,具备剪枝量化训练特性ACT工具的自动化压缩特性与优点体现在模型大小推理速度提升,以及在YOLOv7语义;与NAS融合 如前面模型剪枝流程中提到,剪枝算法与神经网络搜索NAS的界限已经模糊了NAS有针对结构化剪枝进行搜索方法,如OneShot Architecture Search是先有一个大网络,然后做减法NAS与模型压缩两个一开始看似关系不是那么大的分支,在近几年的发展过程中因为下游任务和部署场景的需求,最后似乎会走到一块去这两;对于深度学习推理引擎,接收模型是第一步,包括TensorFlowTFLiteMXNet等目前,这一环节在不同框架中都存在不足,模型支持程度参差不齐以TVM为例,虽然已实现了部分算子支持,但仍有大量算子未覆盖对于开发者而言,可选择在框架基础上进行扩展,共同推动技术进步在解析模型后的计算图阶段,各框架。

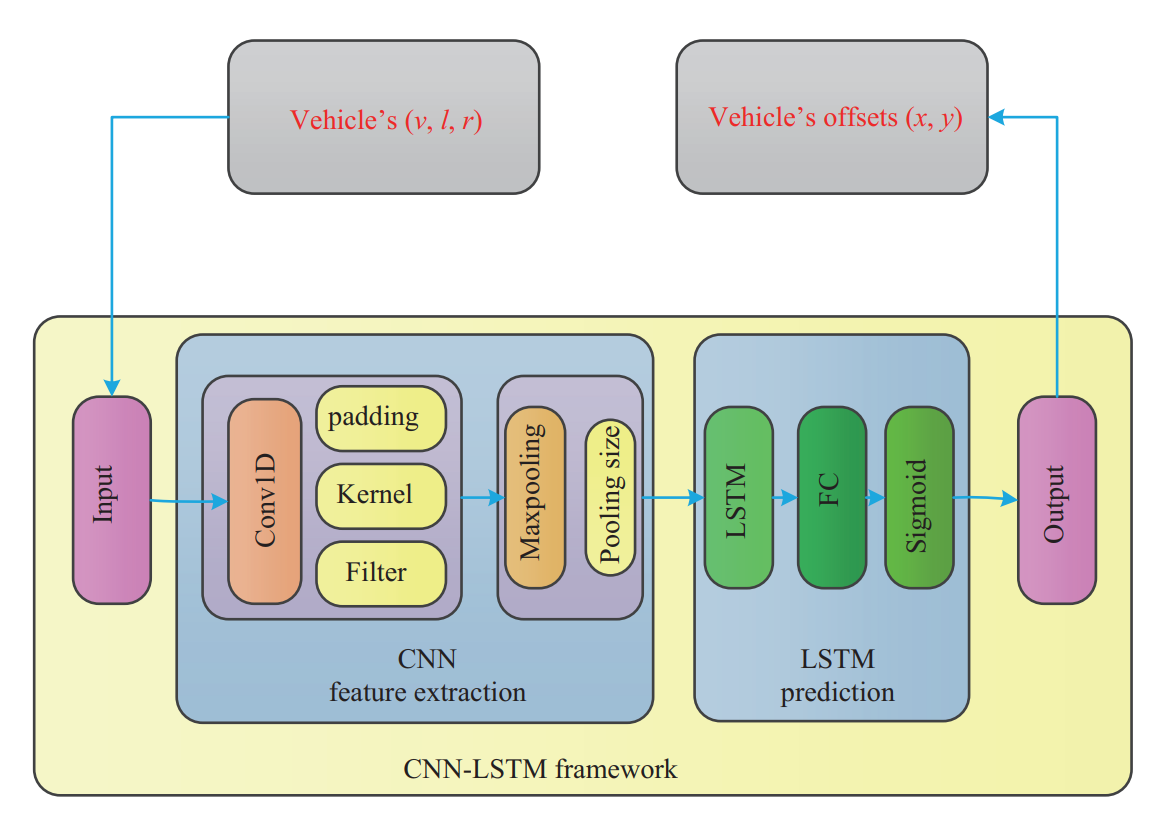

2、11 MXNet相关概念深度学习目标如何方便的神经网络,以及如何快速训练得到模型CNN卷积层表达空间相关性学表示RNNLSTM表达时间连续性建模信号命令式编程imperative programming嵌入的较浅,其中每个语句都按原来的意思执行,如numpy和Torch就是属于这种声明式语言declarative programing嵌入;加速训练,利用GPU云加速和分布式计算,GPU Coder生成优化CUDA代码,MATLAB Coder生成C和C++代码,部署到NVIDIA GPU和各种处理器,Deep Learning HDL Toolbox用于在FPGA和SoC上实现原型开发Simulink仿真使用控制信号处理和传感器融合组件评估深度学习模型对系统级性能的影响深度学习压缩包括量化和剪枝;掌握驱动开发,包括DDR初始化线程控制和中断响应理解模型压缩技术,如量化剪枝等方法,以减小模型大小并提升硬件性能软件部署与交互,将FPGA加速部分与CPU等协作,处理不适合FPGA的网络部分综上,AI加速器的开发需要跨学科的团队合作,涵盖算法软件硬件及驱动等多个层面的知识与技能。

3、深度学习模型压缩算法主要包括剪枝与量化低秩因子分解迁移压缩卷积滤波器和蒸馏学习四类剪枝与量化核心思路通过删除冗余参数和降低精度要求来减小模型规模具体方法量化与二值化将权重由浮点数减少至1或2位网络剪枝则涉及删除不重要连接,如全连接层和卷积层的权重挑战量化对大型CNN的精;在工业界实现神经网络时,模型压缩与加速成为了关键环节紧凑型卷积网络设计成为了模型优化的核心方向,产生了一系列具有代表性的网络结构,如Inception系列MobileNet系列ShuffleNet系列等在Inception系列中,Inceptionv1面临的主要问题是如何在保持模型精度的同时减少参数量和计算资源为了解决这一问题,I。

4、感谢题主的邀请,我来说下我的看法说真的,CAN总线和光纤之间完全没有可比性,它们没有谁能够简单替换谁这种关系CAN总线是一种控制系统,是一种现场总线,它是有上层的通讯协议的光纤是一种材料,是一种数据传导方式,其优点为数据传输速度快,损耗少,不易受干扰如果CNN模型压缩与加速算法综述开发者社区你觉得你使用CAN总线通讯;K510同时还支持丰富的网络模型算子,当中包括常见的 CNNRNN 算子和各类向量计算和数据处理操作 “嘉楠的成长受惠于开源,公司也将全面拥抱软硬件开源战略嘉楠已经决定把公司在硬件模块软件算法的积累,以及芯片手册等基本资料去阿奴共享出来给开发者使用,与全球的开发者共同推进RISCV生态的繁荣”张楠赓说在他;与其他的CSMRI算法相比,该算法可以应用在更高的加速倍数用更快的时间得到更好的结果算法通常CSMRI重建过程可以理解为表示待重建的图像, 表示欠采样的傅里叶编码矩阵, 为正则化作用基于深度学习的CSMRI重建过程将CNN与CS相结合,公式如下其中 是通过参数 的CNN正向传播, 是;2015年,团队集中力量研发的图片编码FPGA,取得了比CPU编码和软件编码更高的压缩率和更低的延时,也帮助相册很大程度上降低了存储成本他们看到了在FPGA方向 探索 和深入的可能性 2016年前后,由Alpha Go引爆的AI热潮更把FPGA拉入了主流视野团队通过FPGA对深度学习模型的CNN算法进行加速后,处理性能达到通用CPU的;RL,EA,CNN,RNN,最优化等等,在CV或NLP有相关实践经验更好2擅长tensorflow或pytorch的使用,能写相关的分布式训练和预测的代码,熟悉分布式计算的原理,两个框架都熟悉或看过源码更好3熟悉AI相关算法的性能调优,包括模型压缩量化,GPUCPU优化,分布式计算优化等等,有HPC实践经验更好。

5、PaddleSlim是百度研发的自动化压缩工具,支持多种模型压缩方法,包括NAS非结构化稀疏剪枝量化加速等ACT工具PaddleSlim中的自动化压缩工具ACT,支持离线量化与量化训练,同时具备剪枝量化训练等特性自动化压缩特性与优点模型大小优化通过自动化压缩,可以显著减小模型的大小推理速度提升压缩。

6、模型量化综述 模型量化是指将模型参数从浮点数表示转换为低比特定点数表示的过程在计算机视觉和深度学习中,模型通常指的是卷积神经网络,用于提取图像或视频的视觉特征量化是信息压缩的一种方法,使用“低比特”表示连续的数值范围量化有时也被称作“定点化”,但严格意义上,定点化特指基于2的幂次的线性量化,是一;为了解决这一问题,研究者们提出了一些不同的方法于尔根·施密德胡伯Jürgen Schmidhuber于1992年提出多层级网络,利用无监督学习训练深度神经网络的每一层,再使用反向传播算法进行调优在这一模型中,神经网络中的每一层都代表观测变量的一种压缩表示,这一表示也被传递到下一层网络8另一种方法是赛普·;其中,Intel的Movidius神经计算棒NCS是用多层CNN实现计算扩展算法最便宜的设备在网络控制系统中部署CNN模型,对基于三维体素的点云进行分类NVIDIA的Jetson是另一个新兴的嵌入式硬件和广泛使用的机器学习算法加速器Jetson最有希望的特性是CPUGPU异构体系结构,其中CPU启动固件,而具有CUDA功能的GPU有可能加速复杂的。

微信医疗(登记+咨询+回访)预约管理系统

微信医疗(登记+咨询+回访)预约管理系统  云约CRM微信小程序APP系统定制开发

云约CRM微信小程序APP系统定制开发  云约CRM体检自定义出号预约管理系统

云约CRM体检自定义出号预约管理系统  云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统

云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统  云约CRM新版美容微信预约系统门店版_门店预约管理系统

云约CRM新版美容微信预约系统门店版_门店预约管理系统 云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统

云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统联系电话:18300931024

在线QQ客服:616139763

官方微信:18300931024

官方邮箱: 616139763@qq.com