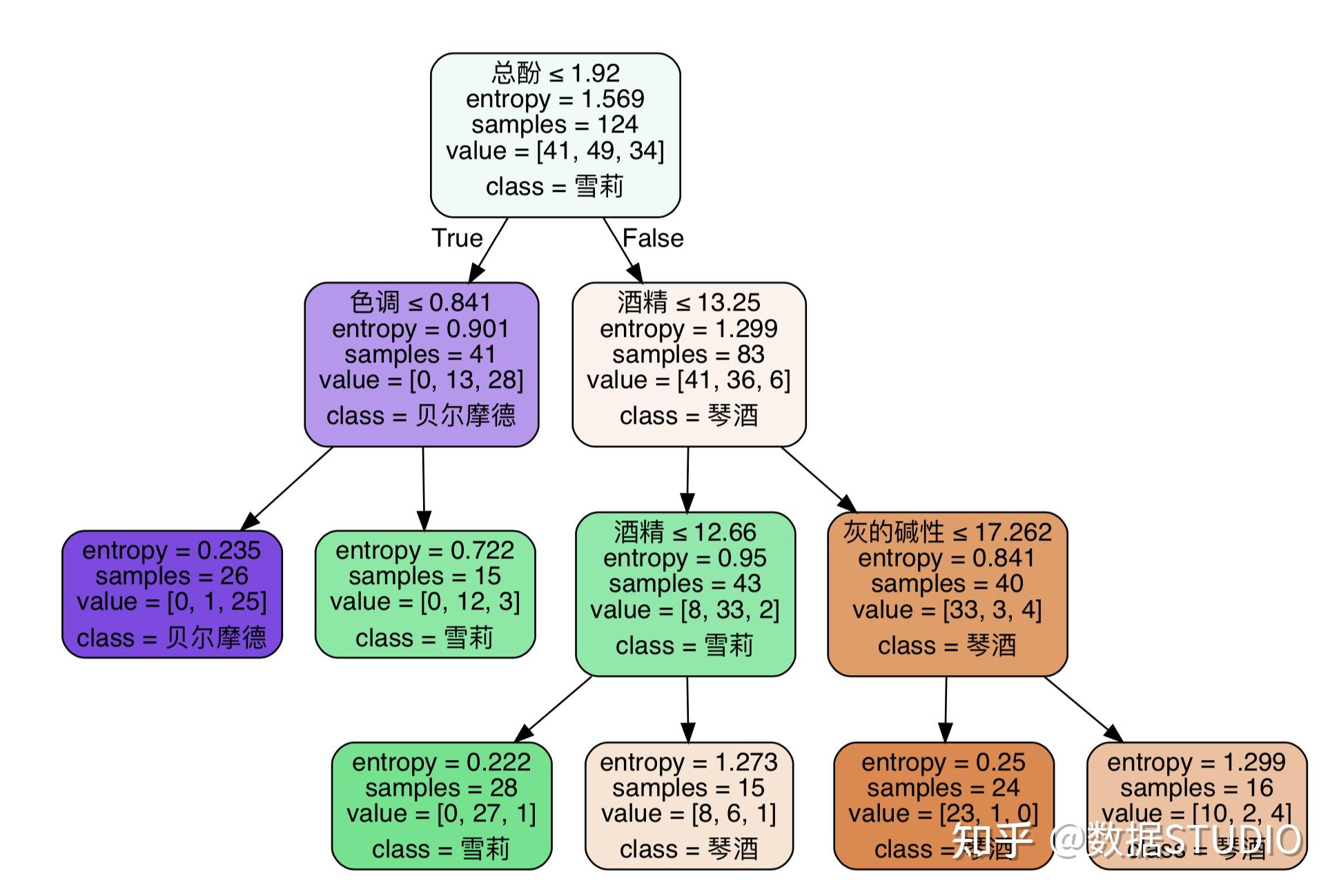

机器学习决策树(ID3)算法及案例我们选取统计学习方法决策树章节的案例,使用样本数据进行分析分类决策树的sklearn实现 在sklearn库中,决策树分类算法通过DecisionTreeClassifier函数实现,回归决策树则通过DecisionTreeRegressor函数实现具体实现代码如下银行贷款申请评估模型的样本数据存储在banktxt文件中,程序逻辑实现于mainpy文件。

4 决策树的标志性算法 ID3C45和CART是决策树的三个标志性算法ID3算法通过信息增益选择最优属性,但存在倾向于选择取值多的属性的缺点 C45算法通过增益率来改进ID3的缺点,提供了更公正的属性选择标准 CART算法则使用基尼系数来选择最优属性,并在sklearn等机器学习库中被广泛使用5。

Python中通过sklearn库实现决策树算法,可以使用DecisionTreeClassifier类,其中criterion参数选择信息增益或信息增益率作为特征选择标准,splitter参数选择最佳分类策略,max_features参数控制考虑特征的数量,max_depth参数控制树的最大深度,以及其机器学习决策树(ID3)算法及案例他参数如min_samples_splitmin_samples_leaf等用于控制决策树的复杂。

既然决策树就是一种特征选择的方法,那么经典决策树算法其实就是使用了不同的特征选择方案 如 1ID3使用信息增益作为特征选择 2C45使用信息增益率作为特征选择 3CART使用GINI系数作为特征选择 具体选择的方法网上一大把,在这里我提供几个链接,不细讲但,不。

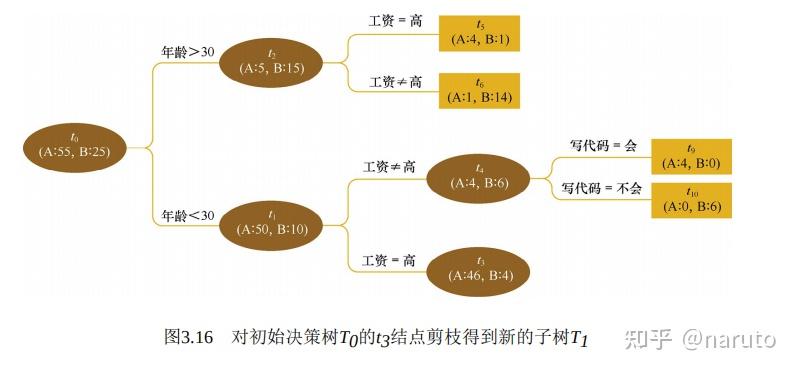

决策树算法是一种用于分类和回归任务的机器学习方法以下是关于决策树算法的详细解答1 决策树的核心 构造决策树通过训练数据集生成决策树,通常涉及损失函数的最小化,以及特征选择决策树生成 剪枝通过测试数据集对决策树进行剪枝,以提高模型的泛化能力,避免过拟合2 决策树的生成过程。

ID3 算法是决策树学习的经典方法,核心是使用信息增益最大的特征作为结点,递归地构建决策树C45 算法是对 ID3 的改进,使用信息增益比作为特征选择准则,并对连续值和缺失值进行处理ID3 算法存在几个不足不能处理连续值,偏向于选择取值较多的特征,不处理缺失值,且没有考虑过拟合问题C45。

后续版本的ID3算法在特征选择上加入了启发式改进,它通过寻找在训练集中最能区分实例的属性来进行分割如果一个属性可以完全分类训练集,算法则停止否则,它会递归地进行n次分割n为一个属性可能划分出的子集数量,选取最优属性ID3采用贪心搜索策略,即每次选择最优属性,不考虑之前的选择决策树。

决策树及ID3算法学习 决策树是一种在机器学习中用于分类的基本方法,它通过构建树形结构来辅助决策分析和行为研究决策树以概率为基础,评估项目风险并判断可行性其结构包含每个内部节点表示属性测试,每个分支表示测试结果,每个叶子节点表示类别决策树算法在监督学习中用于预测模型,构建时需要选择最优。

深入探索决策树的奥秘,我们聚焦于ID3与C45算法,它们如同逻辑的编织者,用ifthen规则的阶梯构建信息的决策之路决策树的核心在于通过信息熵与信息增益寻找最优的决策划分点,它旨在减小数据的不确定性,如同一把锐利的剪刀,切割出清晰的决策边界让我们以ID3为例,信息增益犹如决策树的导航灯,它是。

决策树算法是一种用于分类和回归任务的机器学习方法其核心是通过构建一棵树模型,将输入数据通过一系列决策节点特征属性逐步分割,最终达到预测目标以下是决策树算法和CART算法的精炼详解决策树算法11 决策树简介决策树基于树形结构,每个内部节点表示一个特征属性的测试,每个分支代表一个测试结果。

机器学习中分类和预测算法的评估判定树是一个类似于流程图的树结构其中,每个内部结点表示在一个 属性上的测试 ,每个分支代表一个 属性输出 ,而每个树叶结点代表 类或类分布 树的最顶层是根结点 机器学习中分类方法中的一个重要算法 信息和抽象,如何度量1948年,香农提出了 ”信息熵。

使用决策树实现泰坦尼克号乘客生存率预测的过程主要包括以下几个步骤数据准备使用泰坦尼克号数据集,该数据集包含1313行和11列,涵盖了乘客的多种特征特征可能包括票类别存活状态船票等级年龄登船地点家庭目的地等数据预处理处理缺失值对缺失的数据进行填充或删除,以确保数据完整性。

因而在实际研究数据中,需要特别注意此种情况模型的构建时通常情况下参数设置越复杂,其会带来训练数据的模型评估结果越好,但测试效果却很糟糕,因而在决策树构建时,需要特别注意参数的相关设置,接下来会使用案例数据进行相关说明SPSSAU的操作如下训练集比例默认选择为08即80%150*08=120个。

与其机器学习决策树(ID3)算法及案例他机器学习算法相比,决策树在某些方面也有其独特优势然而,总体上,CART和PCALDA在该数据集上的效果相对较弱综上所述,决策树在Python数据挖掘中是一种重要的工具,具有广泛的应用前景在实战中,需要根据具体任务和数据特点选择合适的特征选择算法和剪枝方法来优化模型性能。

虽然本案例数据质量较好,跳过了一些预处理步骤,但通常在实际应用中,可能需要进行缺失值处理异常值检测与处理数据转换等预处理工作特征归一化归一化特征为确保所有特征在相似的尺度上进行比较,通常需要对特征进行归一化处理构建决策树模型使用Scikitlearn构建模型利用Scikitlearn库中的Decision。

决策树中的分类树是一种基于树形结构的机器学习模型,专门用于解决分类问题以下是关于分类树的详细解答定义与用途分类树的目标是将输入数据划分到不同的类别中它以树形结构表示,通过节点的分裂和叶子节点的类别标签来实现分类构建过程分类树的构建涉及对特征空间的划分,以便在每个子空间内对。

局限性决策树模型容易过拟合,特别是在数据集较小或特征值较多的情况下此外,它对连续型数据的处理能力相对较弱,需要进行离散化处理综上所述,决策树模型是一种强大且灵活的机器学习算法,适用于多种分类和回归任务然而,在使用时需要注意其局限性,并结合具体应用场景进行优化和调整。

上一篇: 关于sqlserver下载安装步骤(sql2005安装教程图解的信息

下一篇: 关于回顾iOS1到iOS15的发展的信息

微信医疗(登记+咨询+回访)预约管理系统

微信医疗(登记+咨询+回访)预约管理系统  云约CRM微信小程序APP系统定制开发

云约CRM微信小程序APP系统定制开发  云约CRM体检自定义出号预约管理系统

云约CRM体检自定义出号预约管理系统  云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统

云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统  云约CRM新版美容微信预约系统门店版_门店预约管理系统

云约CRM新版美容微信预约系统门店版_门店预约管理系统 云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统

云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统联系电话:18300931024

在线QQ客服:616139763

官方微信:18300931024

官方邮箱: 616139763@qq.com