3 多任务学习与小样本学习多任务微调对部分任务有提升快速了解:什么是BERT?,但在某些情况下可能不适用小样本学习方面,BERT对少量数据快速了解:什么是BERT?的处理能力显著4 BERT Large模型的优化对大型BERT模型进行特定任务的微调,可以达到最优结果想深入快速了解:什么是BERT?了解这些技巧,可以参考论文提供的实验代码通过这些策略,你可以更好地优化BERT。

BERT,全称为Bidirectional Encoder Representation from Transformer,是一个基于Transformer模型的创新技术它显著区别于传统的上下文无关的嵌入模型,如word2vec,专注于捕捉文本中的上下文信息BERT的输出结构hidden_rep的形状通常为torchSize,表示一个批次包含1个样本,序列长度为7,每个标记的嵌入维度为。

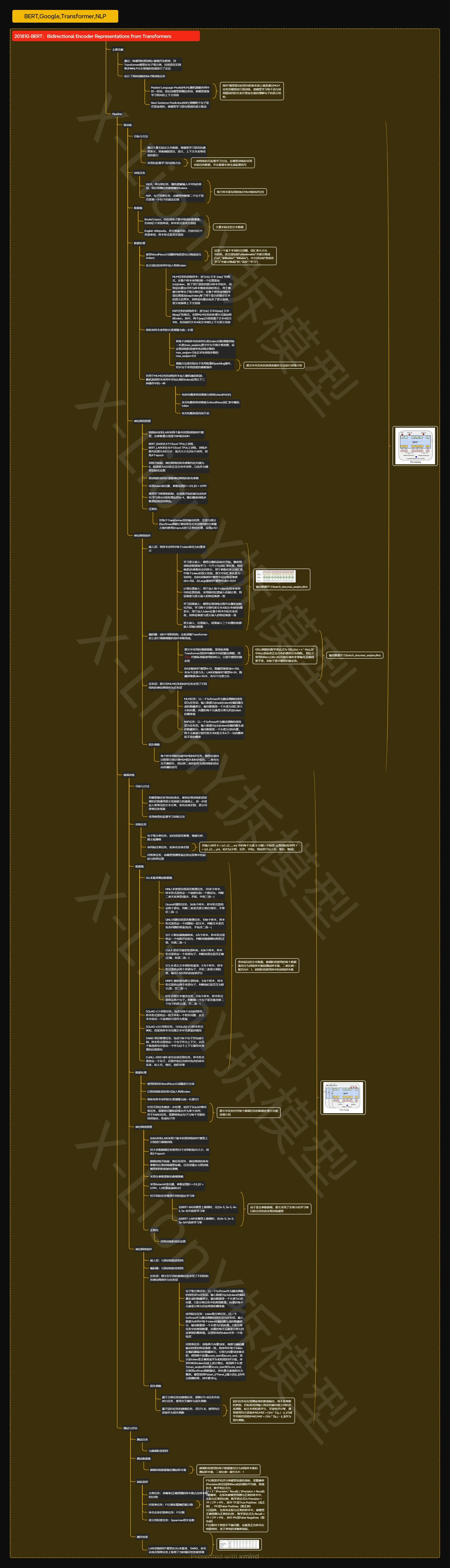

训练逻辑位置pretrainpy核心类BERTTrainer功能包含数据读取模型加载优化器设定损失函数计算分布式GPU支持和迭代训练逻辑损失计算两个任务的损失相加得到总损失通过上述解析,可以较为全面地了解BERT源码的主要组成部分及其功能,有助于深入理解BERT的构造与运行机制。

了解BERT模型BERT由堆叠的Transformer编码器组成,每个编码器包含自注意力层和前馈层BERT输入为一系列标记的tokens,其中特殊的CLS和SEP用于整合文本信息BERT输出是一个768维向量,通常关注CLS位置的表示,用于分类任务数据预处理将文本转换为BERT期望的格式,包括添加CLS和SEP标记。

BERT是一个用于多种下游任务的结构,如回答问题分类和命名实体识别等我们可以将预先训练的BERT视为一个黑盒,它为序列中的每个输入词提供了一个768维的向量表示这些序列可以是一个句子或一对由分隔符SEP分隔以标记CLS开头的句子在后续讨论中,我们将详细解释这些词黑盒的用途是什么。

1导入BERT模型即预训练好的模型2导入预处理模型预处理模型负责将文本转换为适合模型训练的数字矩阵,同时确保输出的数据类型为张量BERT模型有很多,主要区别在于模型的复杂度对于初学者,建议选择Small BERT,虽然精度稍差但训练更快,适合练习三Twitter情感分析 为了演示,我们找到。

BERT是一个基于Transformer Encoder的深度学习模型,用于自然语言处理任务以下是BERT的简要介绍全称Bidirectional Encoder Representations for Transformers架构BERT采用多层双向转换编码架构,这是其与其快速了解:什么是BERT?他类似模型的核心区别之一双向性意味着在编码每个词时,会同时考虑其前后的词,从而捕捉更丰富的上下。

2 BERT预训练数据预处理 BERT通过两个自监督任务进行预训练任务一判断一对句子是否连续预处理时,将句子“你好,我是jack”变为“CLS,你,好,SEP,我,是,jack,SEP”,标签为1,表示连续再从文本中随机选择一句话作为下一句,如“CLS,你,好,SEP,阿,富,汗,独,立,SEP”,标签。

微信医疗(登记+咨询+回访)预约管理系统

微信医疗(登记+咨询+回访)预约管理系统  云约CRM微信小程序APP系统定制开发

云约CRM微信小程序APP系统定制开发  云约CRM体检自定义出号预约管理系统

云约CRM体检自定义出号预约管理系统  云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统

云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统  云约CRM新版美容微信预约系统门店版_门店预约管理系统

云约CRM新版美容微信预约系统门店版_门店预约管理系统 云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统

云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统联系电话:18300931024

在线QQ客服:616139763

官方微信:18300931024

官方邮箱: 616139763@qq.com