LSTM模型在深度学习领域有着广泛LSTM模型详解LSTM模型建立的应用LSTM模型详解LSTM模型建立,特别是在交通领域LSTM模型详解LSTM模型建立的多种问题中例如,它被用于车辆跟驰模型的建立短期交通流预测公交车到站时间预测共享单车需求预测铁路客运量预测以及航空延误预测等本周,我们将详细介绍LSTM的基础理论,并以航空延误预测为例,展示如何建立LSTM模型LSTM全称为“Long S。

在模型结构方面,本文采用的LSTM模型结构如前所述值得注意的是,输入层的大小input_size与输出层的大小output_size需要根据实际数据进行调整在训练过程中,我们训练LSTM模型详解LSTM模型建立了50轮以预测接下来4个时刻的负荷值,并且取得了令人满意的结果,预测的平均绝对百分比误差MAPE为834%关于代码和数据,本文暂。

实际应用中,LSTM可以用于语言模型预测下一个单词词性标注等任务Pytorch提供了丰富的API来实现LSTM模型的构建和训练,如定义模型结构加载预训练权重调整超参数等通过编写简单和完整的示例代码,可以轻松地将LSTM应用于实际问题参考资料详细学习Pytorch LSTM API,请参考 pytorchorgdocsstable。

2 LSTM内部的神经网络 LSTM架构包含输入参数如batch_sizetime_step输入词向量维度和隐藏层神经元个数num_units每个时间步,输入数据维度为batch_size*输入词向量维度,矩阵W维度为输入词向量维度,num_units,隐层输出数据batch_size*num_units矩阵U的维度为num_units,num_units。

多输入多输出LSTM模型的搭建主要包括定义三个全连接层来预测三个变量LSTM输出经过这三个层,分别得到每个变量的预测结果,最后将这些结果合并为一个输出,其形状为n_outputs, output_size,其中n_outputs为预测变量的数量,output_size为每个时刻预测的步数模型训练中,每次预测后得到的label和pred的。

模型构建主要通过attention_net函数完成,该函数综合了双向LSTM和Attention机制注意力模型的计算遵循以下三个公式1 计算上下文向量2 生成注意力权重3 计算加权上下文向量代码中详细展示了这三个步骤的实现,同时对每次计算后的张量尺寸进行了注释为了更直观地理解,避免直接调用torch的soft。

理解为一个神经元在不同时间点的状态,而非隐含层神经元的数量在Pytorch中,LSTM的参数如input_size特征维度hidden_size隐藏层维度num_layers层数batch_first输入维度顺序以及bidirectional双向性等都影响着模型的构建数据输入通常是时间序列的多样本特征立方体,而输出则是一。

新增特征基于现有数据新增湿度压力比列,作为新的特征输入添加日期信息将日期信息添加到数据集中,可能用于后续的时间序列分析或特征工程LSTM模型构建定义LSTM类使用PyTorch框架定义LSTM模型类,包括LSTM层全连接层等设置优化器和损失函数选择合适的优化器和损失函数进行模型训练定义提前停止。

隐藏状态和预测值具体步骤通过公式描述,并在代码实现中得以体现反向传播则是梯度下降的关键步骤,通过从输出开始逆向计算梯度,更新模型参数以减小损失函数,确保模型性能提升在实践中,LSTM可以手写实现,如从头构建,或利用高级库如pytorch进行快速实现,为处理时序数据提供了强大工具。

实现手写实现虽然手写实现LSTM需要从头构建模型,包括定义各个门和细胞记忆单元的计算公式,以及实现前向传播和反向传播算法,但这有助于深入理解LSTM的内部机制和工作原理利用高级库实现为了快速实现LSTM模型并处理时序数据,可以利用高级库如PyTorch这些库提供了丰富的API和工具,使得构建训练和评估。

接着,我们介绍理论模型HoltWinters三参数指数平滑模型考虑趋势季节性和平稳性ARIMA模型结合自回归差分和移动平均特性捕捉序列的自相关性SARIMA模型在ARIMA基础上添加季节性成分,更适应具有季节波动的数据LSTM模型通过门控机制处理长期依赖性模型建立过程中,我们通过ADF检验判断数据平稳性,采用。

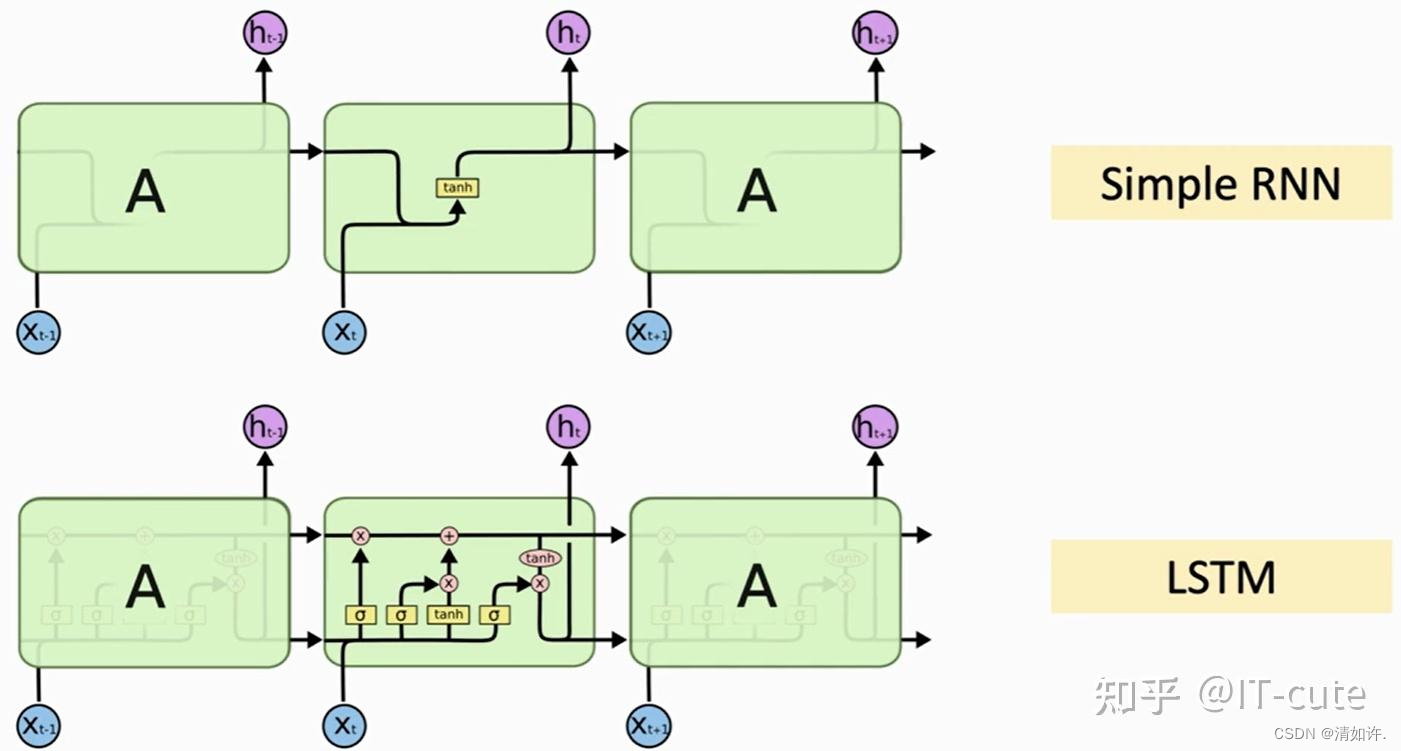

长短期记忆LSTMLSTM 中引入了三个门输入门input gate遗忘门forget gate和输出门output gate,以及与隐藏状态形状相同的记忆细胞某些文献把记忆细胞当成一种特殊隐藏状态,从而记录额外的信息深度循环神经网络到目前为止介绍的循环神经网络只有一个单向的隐藏层,在深度学习应用。

可以学习诗歌数据集中的模式,并生成新诗以下为实现步骤构建LSTM模型训练模型,一般考虑训练时长,简单训练2个epoch加载训练好的模型,输入关键字后,自动生成藏头诗虽然生成的诗句在外观上看起来优雅,但实际上可能不够严谨通过增加训练的epoch和数据集,可以进一步提高模型性能。

循环神经网络结构如图1所示,每个时间步接收输入,计算隐藏状态LSTM结构如图2所示,每个时间步同样接收输入,但更新细胞状态和隐藏状态,结构包含四层网络LSTM计算过程如图3至图6所示遗忘门决定保留上一时刻隐藏状态信息输入门决定接收当前输入信息候选细胞状态根据输入和隐藏状态创建,经过激活函数映射。

LSTM单元内部的门机制详细解释了信息的控制和流动,如遗忘门公式输入门公式和输出门公式,它们分别控制信息的遗忘输入和输出LSTM单元的输出门公式和单元状态更新公式也通过类似的门控操作生成,以计算预测值和下个时间步的输入尽管存在其他模型如GRU和更多复杂结构,研究5表明,LSTM。

前向传播算法包括对输入进行加权变换拆分和激活逻辑门计算单元状态和隐状态输出等步骤反向传播算法基于链式法则和向量微分理论,通过误差的逐层反向传递,更新模型参数LSTM的应用与验证通过沪深300指数的分析,展示了LSTM在时间序列预测上的应用尽管存在外部因素影响和过拟合风险,但LSTM模型仍。

1 LSTM详解 遗忘门 通过S形网络层决定细胞状态中哪些信息应被遗忘,输出值范围01,1表示接受,0表示忽略 输入门 分为两部分,一是更新所需信息的S形网络层,二是创建新值的公式网络层,用于细胞状态更新 细胞状态更新 基于遗忘和输入门的决定,更新旧状态为新的候选值与旧值的。

上一篇: windows10虚拟机服务器,windows server 虚拟机

下一篇: 3个工具助你玩转正则表达式的简单介绍

微信医疗(登记+咨询+回访)预约管理系统

微信医疗(登记+咨询+回访)预约管理系统  云约CRM微信小程序APP系统定制开发

云约CRM微信小程序APP系统定制开发  云约CRM体检自定义出号预约管理系统

云约CRM体检自定义出号预约管理系统  云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统

云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统  云约CRM新版美容微信预约系统门店版_门店预约管理系统

云约CRM新版美容微信预约系统门店版_门店预约管理系统 云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统

云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统联系电话:18300931024

在线QQ客服:616139763

官方微信:18300931024

官方邮箱: 616139763@qq.com