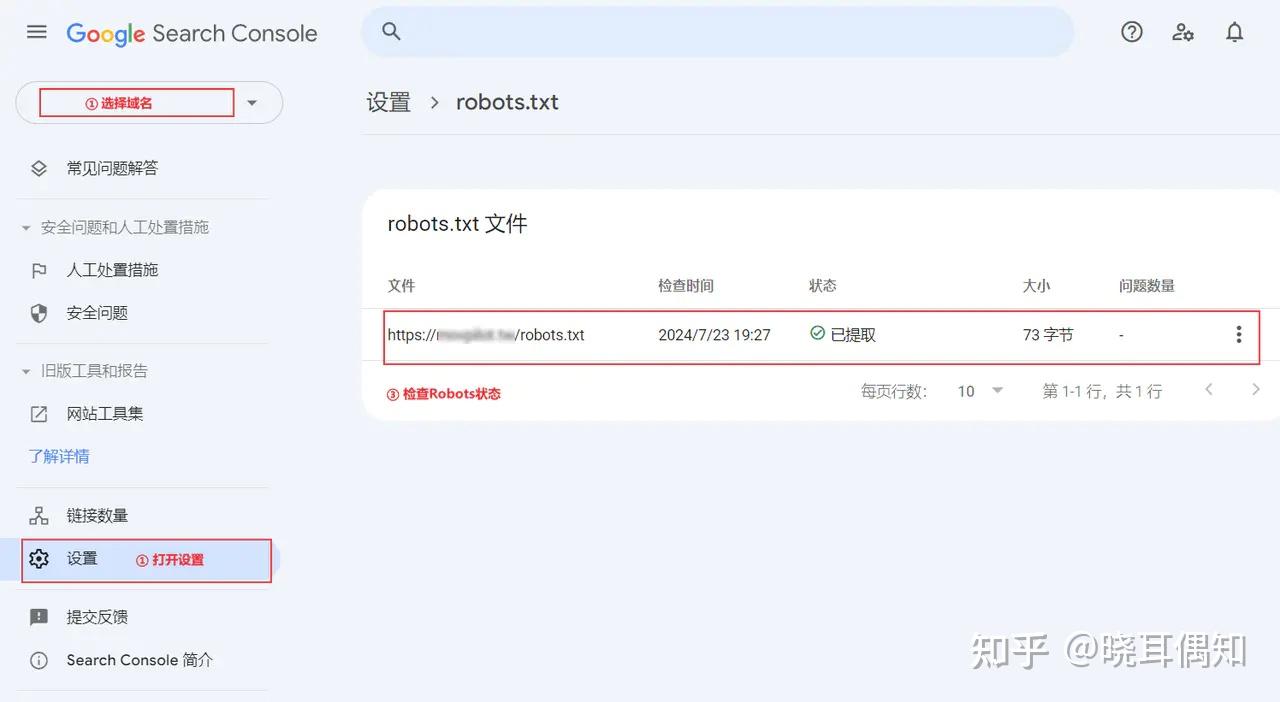

Robots协议,全称网络爬虫排除标准Robots Exclusion Protocol,其目的是让网站明确告知搜索引擎哪些页面可以抓取,哪些不可以Robots协议文件是一种ASCII编码的文本文件,通常位于网站的根目录下,它帮助网站向搜索引擎的漫游器爬虫传递不可访问页面的信息举例理解想象网站为酒店,Robotstxt为房间。

什么是robotstxt搜索引擎使用spider程序自动访问互联网上的网页并获取网页信息spider在访问一个网站时,会首先会检查该网站的根域下是否有一个叫做robotstxt的纯文本文件您可以在您的网站中创建一个纯文本文件robotstxt,在文件中声明该网站中不想被robot访问的部分或者指定搜索引擎只收录特定的部分请注意。

robotstxt撰写方法1,允许所有的搜索引擎访问网站的所有部分或者建立一个空白的文本文档,命名为robotstxtUseragent*Disallow或者Useragent*Allow 2,禁止所有搜索引擎访问网站的所有部分Useragent*Disallow 3,禁止百度索引robots.txt怎么写你的网站UseragentBaiduspiderDisallow。

Robotstxt文件的写法详细介绍如下禁止所有搜索引擎抓取任何页面Useragent *Disallow 允许所有搜索引擎抓取所有页面Useragent *Allow 仅允许特定搜索引擎抓取针对特定搜索引擎,如百度和谷歌Useragent baiduspiderAllow Useragent googlebotAllow 禁止其robots.txt怎么写他所有搜索引擎Useragent *Disallow。

微信医疗(登记+咨询+回访)预约管理系统

微信医疗(登记+咨询+回访)预约管理系统  云约CRM微信小程序APP系统定制开发

云约CRM微信小程序APP系统定制开发  云约CRM体检自定义出号预约管理系统

云约CRM体检自定义出号预约管理系统  云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统

云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统  云约CRM新版美容微信预约系统门店版_门店预约管理系统

云约CRM新版美容微信预约系统门店版_门店预约管理系统 云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统

云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统联系电话:18300931024

在线QQ客服:616139763

官方微信:18300931024

官方邮箱: 616139763@qq.com