Scrapy是用Python语言编写的一个快速高层次的web数据抓取框架以下是关于Scrapy的详细介绍定义与用途Scrapy旨在帮助用户轻松实现从web站点抓取数据并提取结构化信息的功能它适用于数据挖掘监测以及大规模的数据采集任务,如常规网页采集和大型架构的支持,甚至支持分布式抓取框架特性作为一个框架scrapy;scrapy 是一个通用的爬虫框架,其功能比较完善,可以帮你迅速的写一个简单爬虫,并且跑起来scrapyredis是为了更方便地实现scrapy分布式爬取,而提供了一些以redis为基础的组件注意,scrapyredis只是一些组件,而不是一个完整的框架可以这么认为,scrapy是一工厂,能够出产你要的spider而scrapy;scrapy的缺点 功能设置相对固定无法像pyspider那样灵活配置爬取行为,对于需要高度定制化需求的项目可能有所限制综上所述,选择pyspider还是scrapy取决于具体项目的需求如果项目需要高度的灵活性和可配置性,pyspider可能是更好的选择而对于更注重性能和稳定性的项目,scrapy则显得更加合适。

# Scrapy settings for mySpider projectBOT_NAME = #39mySpider#39 # scrapy项目名SPIDER_MODULES = #39mySpiderspiders#39NEWSPIDER_MODULE = #39mySpiderspiders#39# Obey robotstxt rulesROBOTSTXT_OBEY = False # 是否遵守协议,一般给位false,但是创建完项目是是True,我们把它改为False# Configure maximu;Scrapy是一个快速高层次的Web抓取和网页抓取框架,用于抓取web站点并从页面中提取结构化的数据它使用了Twisted异步网络框架,支持并发请求,性能较高实现过程创建一个Scrapy项目定义一个Spider类,设置起始URL和解析方法在解析方法中,使用XPath或CSS选择器提取数据运行Spider,抓取数据效率在;常见的网络爬虫工具主要包括以下几类一基于Python的爬虫工具 Scrapy 简介Scrapy是一个功能强大且成熟的Python爬虫框架,具有高度的可扩展性和灵活性特点支持异步处理,能够高效地抓取大量数据开发者可以使用它定义抓取规则处理请求和响应以及对数据进行清洗和存储等操作例如,对于新闻网站的;Scrapyredis是一个分布式爬虫框架,主要用于解决Scrapy框架不支持分布式的问题其用法如下安装与配置在master机器上安装redis在scrapy爬虫机器上安装scrapyredis,使用命令pip install scrapyredis在settingspy中设置相关配置,Scrapyredis已完成任务调度启动与调度启动scrapy,使用Scrapyredis的调度器对;Pyspider的一大优点是其直观的Web UI,使得调试过程更为便捷,相比之下,Scrapy主要依赖于parse命令进行调试,便利性略逊一筹Pyspider内置PyQuery作为选择器,而Scrapy则支持XPathCSS选择器和正则表达式,灵活性更强对于快速抓取普通新闻网站这类需求,Pyspider的开发效率更高,如获取某个新闻网站的内容。

Scrapy提供了Shell交互测试环境,允许开发者在开发过程中快速测试和调试爬虫代码这使得爬虫的开发和调试更加便捷和高效四Scrapy的应用场景Scrapy作为一个功能强大的爬虫框架,适用于多种应用场景它特别适合于需要处理大量数据进行分布式部署和协同工作的爬虫项目同时,Scrapy也支持对动态加载页面的;在Scrapy中设置随机UserAgent的方法主要有以下几种使用fake_useragent包并手动设置安装fake_useragent包首先需要安装fake_useragent包在主程序中设置虽然可以通过一行代码实现随机更换,但这种方法要求每个请求都手动设置,不够高效在settingspy文件中手动添加自定义UserAgent可以在settingspy文件;Python数据分析及可视化中的Pyspider与Scrapy简介Scrapy框架功能Scrapy是一个功能强大的爬虫框架,支持多线程并行抓取适用场景适用于大规模数据集的抓取任务优势拥有更完善的社区支持丰富的文档资源以及成熟的框架设计,在开发者社区中认可度高Pyspider框架功能Pyspider是一个基于分布式计算的。

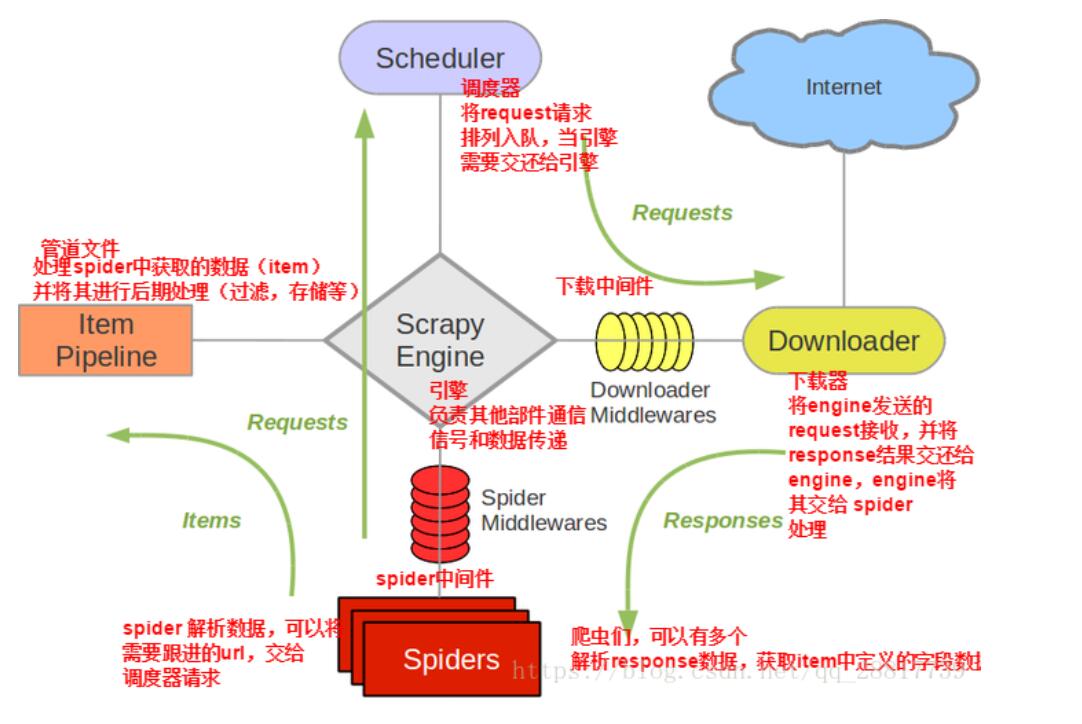

具体组件如下引擎Scrapy用来处理整个系统的数据流处理,触发事务框架核心调度器Scheler用来接受引擎发过来的请求,压入队列中,并在引擎再次请求的时候返回可以想像成一个URL抓取网页的网址或者说是链接的优先队列,由它来决定下一个要抓取的网址是什么,同时去除重复的网址 下载器;动漫爱好者使用Scrapy爬虫框架进行多页爬取图片信息的步骤如下确定目标并创建项目确定目标网站,例如Konachannet,用于获取高清动漫壁纸创建一个新的Scrapy项目,并编写相应的爬虫文件解析主页并获取图片链接在爬虫文件中,解析主页内容,识别出class为rdquothumbrdquo的div元素提取这些div元素中的;Pyspider和Scrapy的区别主要包括以下几点调试便利性Pyspider具有直观的Web UI界面,使得调试过程更为便捷Scrapy主要依赖于parse命令进行调试,相比Pyspider的Web UI,便利性略逊一筹选择器灵活性Pyspider内置PyQuery作为选择器,选择方式相对固定Scrapy支持XPathCSS选择器和正则表达式,选择器;Python爬虫入门Scrapy框架中的Spider类介绍 Spider类定义与作用 定义Spider是Scrapy框架提供的一个基本类,用于定义如何抓取某个网站,包括执行抓取操作和从网页中提取结构化数据 作用其scrapy他类如CrawlSpider等都需要从Spider类中继承,实现特定网站的抓取逻辑ScrapySpider类的常用属性 name字符串。

微信医疗(登记+咨询+回访)预约管理系统

微信医疗(登记+咨询+回访)预约管理系统  云约CRM微信小程序APP系统定制开发

云约CRM微信小程序APP系统定制开发  云约CRM体检自定义出号预约管理系统

云约CRM体检自定义出号预约管理系统  云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统

云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统  云约CRM新版美容微信预约系统门店版_门店预约管理系统

云约CRM新版美容微信预约系统门店版_门店预约管理系统 云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统

云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统联系电话:18300931024

在线QQ客服:616139763

官方微信:18300931024

官方邮箱: 616139763@qq.com